De laatste jaren groeit de omvang van gedigitaliseerde collecties historische tekstdocumenten exponentieel, dankzij de inspanningen van archieven, bibliotheken, musea, en andere erfgoedinstellingen. De schaal waarop deze informatie beschikbaar wordt, spoort onderzoekers aan nieuwe methoden voor tekstanalyse te verkennen. Of je nu snel op zoek bent naar bepaalde informatie (“keyword spotting”), een eenvoudig overzicht wilt krijgen van de inhoud (“topic modelling”), of een document onderdeel vormt van een doorgedreven corpusanalyse (“text mining”): de basisvoorwaarde is dat de tekst vervat in de digitale beelden, machine-leesbaar is. In dit onderdeel doorlopen we alle stappen van scan naar digitale tekst.

Het kiezen van software voor automatische tekstherkenning

Command line interface of graphical user interface

Net als geldt voor het veld van de digitale tekstverwerking en -analyse in het algemeen, komt een aanzienlijk aantal tools voor automatische tekstherkenning zonder de gebruiksvriendelijke grafische gebruiksomgeving (“graphical user interface” of “GUI”) waarbij gebruikers m.b.v. vensters, menu’s, en pictogrammen doorheen een computerprogramma kunnen navigeren. Kennis verwerven van een opdrachtregelinterface (“command line interface” of “CLI”) zoals PowerShell (Windows) of Bash (Mac en Linux), en van scripttalen als Python is daarom een groot pluspunt. Met behulp van een scripttaal moet de gebruiker regels tekst die de instructies voor het computerprogramma bevatten, invoeren in de command line interface. De voordelen van scripting zijn snelheid en maatwerk: het automatiseren van repetitieve taken en het vrij combineren van de tools die het meest geschikt zijn voor de documenten waarmee je werkt. Programma’s met een GUI zijn daarentegen toegankelijker, want vereisen helemaal geen programmeerervaring.

Optische tekenherkenning (OCR) is standaard ingebouwd in propriëtaire (betalende) software voor het beheren van PDF’s, zoals Adobe Acrobat en ABBYY FineReader. ABBYY is één van de meest gebruikte OCR-applicaties ter wereld: het programma is eenvoudig in gebruik, incorporeert scanning en pre-processing, en presteert goed op hedendaagse talen en lettertypes (gedrukte tekst). Je kan er echter geen model mee trainen op je eigen data, een belangrijke beperking voor wie werkt met oude drukken of handgeschreven documenten. Transkribus is een gebruiksvriendelijk alternatief dat zich in het bijzonder richt op Handwritten Text Recognition (HTR) van historische documenten. Het platform wordt beheerd als coöperatie (door de READ-COOP) en de transcriptie van documenten is sinds 2019 betalend. Elke gebruiker ontvangt wel 500 gratis credits, goed voor het verwerken van zo’n 500 handgeschreven of 3000 gedrukte pagina’s. eScriptorium ontwikkelt zich op dit moment als een gratis alternatief voor Transkribus voor de annotatie en transcriptie van historische tekstdocumenten. De grafische gebruiksomgeving is een “web-based user interface”, waarbij de gebruiker in de browser werkt i.p.v. met een desktopapplicatie.

De meest bekende OCR-machine zonder grafische

gebruiksinterface (GUI) is Tesseract, ontwikkeld eind jaren ‘80, en sinds 2006 beheerd

door Google. De flexibiliteit van de “command line interface” in combinatie met de open

licentie verklaren de populariteit van de software. Hoewel Tesseract veel

gebruikt wordt binnen de Digital Humanities, is de tool weinig geschikt voor de

automatische herkenning van handgeschreven tekst. Je kan er wel modellen op

trainen voor gedrukte documenten. Dankzij de open source licentie, vind je de

software tevens geïntegreerd in andere applicaties, die de

gebruiksvriendelijkheid ervan verhogen met een GUI (maar de manipuleerbaarheid

verlagen), of ingebouwde functionaliteiten toevoegen (bv. OCRmyPDF). Aan de Universität Bielefeld ontwikkelt men nopaque,

een applicatie met een “web-based user interface” die naast de Tesseract

OCR-software de volledige pipeline van databeheer tot analyse van digitale

teksten met Natural Language Processing (integratie van spaCy) toegankelijk

maakt voor Digital Humanities onderzoekers met beperkte programmeerervaring. Google biedt tevens

command-line functionaliteiten voor tekstherkenning aan als onderdeel van hun

werk m.b.t. beeldherkenning: Google Cloud Vision API. Door het grote aantal beeldgegevens dat Google ter beschikking heeft voor

modeltraining, geeft Google Vision goede resultaten voor tekst op afbeeldingen

als in documenten, handgeschreven of elk ander lettertype (zelfs op foto’s van

straatnaamborden). Een model trainen voor eigen data is echter niet mogelijk, de

service is betalend (via credits), en kennis van een programmeertaal als Java,

Javascript, of Python is absoluut vereist.

Optical

Character Recognition of Handwritten Text Recognition

In tweede instantie bepalen de eigenschappen van de bron de keuze voor de transcriptiesoftware. Tools voor optische tekenherkenning (“Optical Character Recognition” of “OCR”) zijn ontworpen voor de automatische omzetting van afbeeldingen (scans) van hedendaagse, gedrukte documenten naar digitale tekst. Zoals de naam zegt, maakt de methode van optische tekenherkenning gebruik van de regelmatige witruimten tussen woorden en tekens voor de segmentatie van de tekst. De individuele karakters worden vergeleken met een template, en vervolgens wordt de spelling van de geëxtraheerde woorden gecontroleerd a.d.h.v. een woordenboek. Voor handgeschreven documenten (die niet gesegmenteerd kunnen worden in individuele tekens) of oude drukken (met historische lettertypes en/of spelling) zijn programma’s ontworpen voor de transcriptie van historische documenten dus in de meeste gevallen een beter alternatief. Handschriftherkenning (“Handwritten Text Recognition” of “HTR”) ontwikkelde zich vanwege de hogere complexiteit als een afzonderlijk veld binnen de computerwetenschappen. Moderne technieken gebaseerd op kunstmatige intelligentie (“machine learning” en “neural networks”, zgn. RNN) vormen tevens de basis voor tools als Transkribus, dat zich richt op onderzoekers in de historische en literatuurwetenschappen, en de erfgoedsector. Het basisprincipe is daarbij dat niet elk teken afzonderlijk, maar alle tekens in de context van de hele tekstregel (als “gegevenssequentie”) worden geïnterpreteerd.

OCR-programma’s

(evt. met een grafische gebruiksomgeving) hebben het voordeel makkelijk én snel

te werken. Voor gedrukte bronnen uit de 19de en 20ste eeuw (zoals historische kranten) heb je mogelijk ook met reguliere OCR behoorlijke resultaten. De ingebouwde voorbewerking van documenten en

betrouwbaarheid van de methode van tekenherkenning door segmentatie,

compenseren mogelijk de transcriptiefouten als gevolg van het hedendaagse

taalmodel. Ongeacht de methode biedt automatische tekstherkenning immers nooit

een garantie op 100% nauwkeurigheid.

Artificiële intelligentie of crowdsourcing

Mensen zijn (voorlopig) nog steeds beter in het interpreteren van tekstindeling en het ontcijferen van handschriften dan machines. Wie een hoge graad van nauwkeurigheid beoogt of werkt met documenten met een complexe lay-out (zoals tabellen), kan de inzet van een crowdsourcingplatform overwegen. Gescande documenten worden daarbij door vrijwilligers getranscribeerd m.b.v. een online toepassing en een invoerschema. Het platform VeleHanden, een initiatief van het Stadsarchief Amsterdam, omvat het grootst aantal projecten en de grootste gemeenschap van vrijwilligers (20 000 in januari 2021) voor de ontsluiting en digitalisatie van erfgoedcollecties in het Nederlandse taalgebied. In opbouw is Madoc, een IIIF-gebaseerd annotatie- en crowdsourcingplatform ontstaan uit de samenwerking van Vlaamse universiteiten. Madoc richt zich zowel op individuele onderzoekers als op grote projecten, en biedt de mogelijkheid output te genereren als “linked data” (die naast machine-leesbaar, dus ook machine-begrijpbaar is). Het opzetten van crowdsourcing verzekert je van een hoogkwalitatieve digitalisering van documenten, maar brengt ook eigen uitdagingen met zich mee: het verzamelen en motiveren van vrijwilligers, het opzetten van een invoerschema, en het investeren van tijd in het beantwoorden van vragen en controleren van de resultaten.

Vrijwilligerswerking combineren met artificiële intelligentie vraagt minder mensen en middelen. HTR-platforms gericht op historische documenten als Transkribus en eScriptorium bieden de optie aan om collecties te delen met andere gebruikers met het oog op samenwerking. De transcripties vervaardigd door de verschillende gebruikers kunnen vervolgens dienen als “ground truth” data (gouden standaard) voor het trainen van een HTR-model. De beeldkwaliteit en coherentie van het handschrift bepalen, samen met de omvang van het trainingscorpus, de kwaliteit van het model en de resulterende automatische digitalisatie.

Niet iedereen is op zoek naar een “woord voor woord” transcriptie. Soms is het voldoende om een afgebeelde tekst doorzoekbaar te maken. Het creëren en corrigeren van een digitale tekst waarop je kan full text-zoeken is dan niet nodig. “Keyword spotting” spoort alle mogelijke matches voor een zoekterm op, en lijst ze op vergezeld van een waarschijnlijkheidsscore. Op die manier omvatten de zoekresultaten ook woorden die foutief getranscribeerd of gedrukt werden, en historische of persoonlijke spellingsvarianten. Artificiële intelligentie heeft dus het potentieel de toegankelijkheid van digitale collecties revolutionair te veranderen.

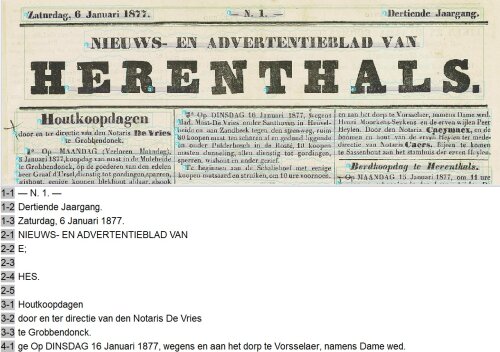

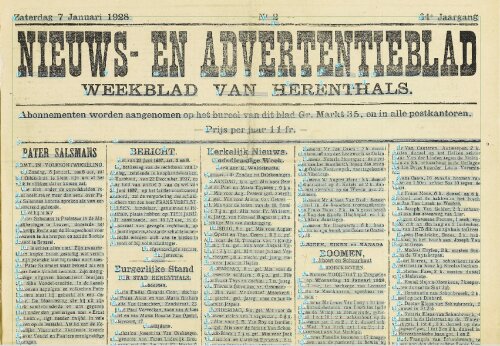

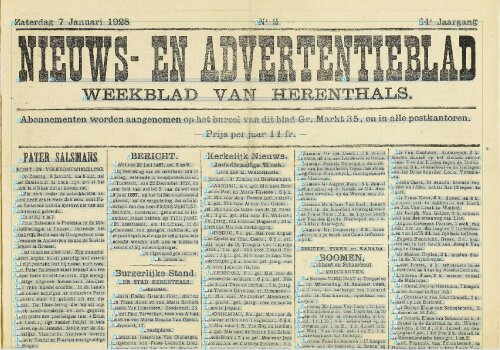

Testcase: het "Nieuws- en Advertentieblad van Herenthals"

In het “Time Machine: Herentals en de Kleine Nete” project konden we aan de slag met een historisch krantencorpus dat ter beschikking werd gesteld door het Stadsarchief Herentals. Het Nieuws- en Advertentieblad van Herenthals, een katholiek weekblad met aankondigingen van de verkoop van landbouwproducten op het einde van de 19de en begin van de 20ste eeuw, werd in 2015 gedigitaliseerd voor de periode 1876-1928. Door middel van Optical Character Recognition (OCR) werden de scans doorzoekbaar gemaakt voor raadpleging op de website Kempens Erfgoed, een online platform dat het erfgoed uit de Antwerpse Kempen samenbrengt op initiatief van de erfgoedcellen Erfgoed Noorderkempen, Kempens Karakter, en k.Erf. Krantencollecties als deze bevatten een schat aan informatie over de lokale economie en evoluties in het landgebruik op een moment dat de landbouw in de vallei van de Kleine Nete grondig transformeerde.

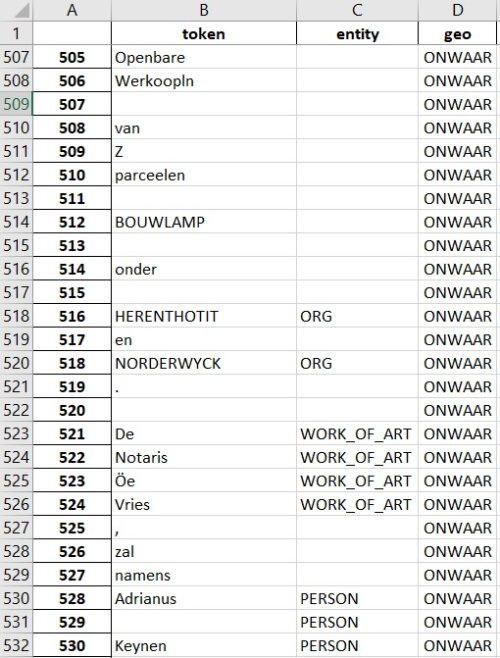

De digitale kranten werden aangeleverd in PDF en METS/ALTO, een XML-schema waarbij METS de metadata en structurele informatie en ALTO informatie over de lay-out en de OCR-transcriptie van elke digitale pagina bevat. Een eerste test met een Named Entity Recognition (NER) model en identificatie van plaatsnamen a.d.h.v. de eigen gazetteer maakte duidelijk dat de kwaliteit van de automatische tekstherkenning (hier OCR) onvoldoende was voor het gebruik van het Nieuws- en Advertentieblad als test-case voor data-extractie. We onderzochten of het trainen van een model in het Handwritten Text Recognition (HTR) programma Transkribus de nauwkeurigheid van de transcriptie kon verhogen.

Fragment uit de resultaten van een eerste test met een Named Entity Recognition (NER) standaardmodel voor hedendaagse kranten en de identificatie van plaatsnamen a.d.h.v. de "Time Machine" historische plaatsnamengazetteer: door de foutieve transcriptie labelt het NER-model “Herenthout” als “organisatie”, en wordt de plaatsnaam niet gematcht met de gazetteer.

Een eerste stap in Handwritten Text Recognition met Transkribus is het testen van de bruikbaarheid van de publieke modellen die reeds beschikbaar zijn in het systeem. Onderzoekers en instellingen kunnen eigen modellen ter beschikking stellen aan andere gebruikers wanneer die succesvol getraind werden op een voldoende groot en divers corpus. Naast de taal, periode, het lettertype (handgeschreven of gedrukt), en het aantal woorden en tekstregels waarop het model trainde, moeten volgende technische criteria in overweging worden genomen bij het selecteren van een publiek model: de “Character Error Rate” (CER) - het percentage van de tekens dat verkeerd getranscribeerd werd door het model - en het aantal “epochs” - het aantal keer dat de training data geëvalueerd werden door het “neural network”. Een CER lager dan 10% is aanvaardbaar om de digitale tekst (machine-)leesbaar te maken; een hogere foutenmarge laat echter nog “Keyword Spotting” (KWS) toe. Bij handgeschreven documenten ligt, door de onregelmatige vorm van de karakters, de CER steeds hoger dan bij gedrukte tekst, waarbij een CER van slechts 1% haalbaar is. Voor het trainen van een model op een beperkt corpus zijn 50 “epochs” voldoende; grotere modellen met een hoge diversiteit aan handschriften of lettertypen trainen best langer.

Op het moment van de test op het Nieuws- en Advertentieblad werkten we in Transkribus versie 1.11.0. Naast het HTR-algoritme was toen ook ABBYY FineReader (OCR) in het platform ingebouwd. We selecteerden ABBYY en de publieke HTR-modellen Transkribus print 0.1, Dutch_Gothic_Print en ONB_Newseye. Transkribus print 0.1 (inmiddels is men aan versie 0.3) werd door het Transkribus Team zelf getraind op een variëteit aan gedrukt materiaal, voor verscheidene Europese talen. Dutch_Gothic_Print resulteerde uit het “Entangled History” project op basis van 16de- tot 18de-eeuwse ordonnantieboeken van het KB Lab (Koninklijke Bibliotheek van Nederland). ONB_Newseye werd ontwikkeld door de Österreichische Nationalbibliothek voor de transcriptie van Duitstalige kranten uit de 19de en 20ste eeuw, in het kader van het NewsEye project.

De

automatische tekstherkenning met de ABBYY OCR-engine was reeds aanzienlijk

accurater dan de originele OCR. ABBYY signaleerde ook beter woordafbrekingen,

maar berustte hier en daar te veel op het woordenboek (onnodige

spellingswijzigingen). De integratie van segmentatie (lay-outanalyse) pleit

tevens in het voordeel van het kiezen voor OCR-software bij de transcriptie van

historische kranten: de automatische herkenning van tekstregels en het toekennen

van de juiste leesvolgorde - geen evidentie wanneer een pagina opgedeeld is in

3 tot 5 kolommen - doet ABBYY voorlopig beter dan de tools voor

(semi-)automatische lay-outanalyse in Transkribus. Van de publieke HTR-modellen

kwam het best getrainde Transkribus print 0.1 er ook het beste uit. In het

kader van de test gebeurde de segmentatie van de complexe krantenlay-out in

“text regions” vooraf handmatig, in combinatie met automatische herkenning van

de “baselines” met de CITlab LA module. Transkribus print 0.1 scoorde nog beter dan ABBYY op nauwkeurigheid wat betreft

het aantal karakterfouten, maar dat gold niet voor de woordafbrekingen.

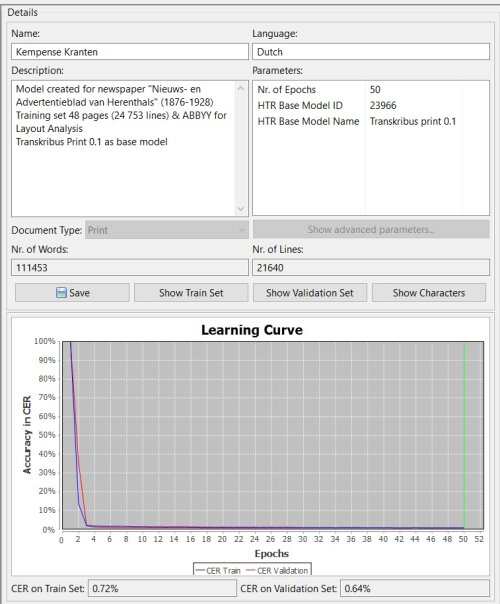

Uit de verkenning van de modellen en tests op de data werd besloten tot de creatie een training set waarvoor een eerste transcriptie werd gegenereerd a.d.h.v. de combinatie van ABBYY met Transkribus print 0.1. Deze methode elimineerde de afzonderlijke segmentatiefase vooraf en minimaliseerde het transcriptie- en correctiewerk voor het bekomen van een “ground truth” (gouden standaard) versie. De goede resultaten m.b.t. het herkennen van karakters met Transkribus print 0.1 betekende dat de meeste correcties betrekking hadden op de woordafbrekingen. Uit de scans van het Nieuws- en Advertentieblad werden 48 pagina’s geselecteerd representatief voor de hele collectie: 2 edities per decennium (de eerste en laatste edities van 1876, 1886, 1896, 1906, 1916, 1926, telkens 4 pagina’s, meer dan 20 000 lijnen en 100 000 woorden). De gecorrigeerde transcripties werden, samen met Transkribus print 0.1 als basismodel, getraind tot het model “Kempense Kranten”. De duurtijd van de training was 1 uur en 52 minuten. Het resultaat had een uitstekende “Character Error Rate” (CER van 0,64% op de validatieset).

Technisch overzicht van het Handwritten Text Recognition model “Kempense

Kranten” getraind in Transkribus op het “Nieuws- en Advertentieblad van

Herenthals” in het kader van het Time Machine project. De goede resultaten doen

vermoeden dat het model geschikt kan zijn voor toepassing op andere historische

kranten voor dezelfde regio en periode.

Toegepast op de digitale afbeeldingen van edities uit de krantencollectie die geen deel uitmaakten van de training set, betekende het eigen trainde HTR-model “Kempense Kranten” een verbetering op frequente karakterfouten van het Transkribus print 0.1 model: het onderscheid tussen trema’s en accenten, tussen de letters i/f/t en o/e/c, de cijfers 3 en 5, en de hoofdletter I en het cijfer 1. Woordafbrekingen werden telkens geïndiceerd, weliswaar overijverig, gezien het model het verschil tussen een weglatingsstreepje en een koppelteken tussen twee eigennamen (bv. “Graaf de Merode-Westerloo”) niet kan interpreteren.

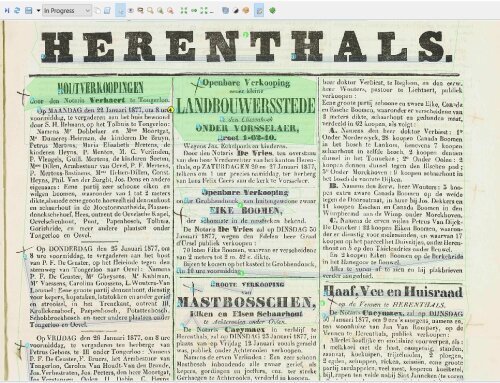

Enkele tekstherkenningsfouten bleken echter systematisch hardnekkig. Allen hielden verband met de segmentatie van de complexe lay-out van de krant in titels, kolommen, tabellen, en tekstregels voorafgaand aan de transcriptie van de afgebeelde tekst. Het gros van de transcriptiefouten situeerde zich bij de krantenkoppen: door de tekengrootte werd de “baseline” onderbroken, en omvatte de “line region” niet de gehele letter. De Transkribus documentatie stelt dat de “baseline”, de lijn die tijdens de segmentatie door de “CITlab Layout Analysis” tool onder de tekstregel aangebracht wordt, het belangrijkst is voor de tekstherkenning die volgt. De “line region”, de polygoon die tegelijk met de “baseline” automatisch wordt gegenereerd voor het aanduiden van de tekengrootte, was bij de krantenkoppen echter veelal foutief, wat de nauwkeurigheid van het model sterk nadelig bleek te beïnvloeden. Op scans met een lagere beeldkwaliteit ging echter ook de transcriptie van het tekstcorpus af en toe de mist in. We stelden vast dat de lay-outanalyse door ABBYY, die vanwege de training set in het model “Kempense Kranten” vervat zit, beter presteert dan “CITlab Layout Analysis” en tekstherkenning in twee fasen, wat betreft de segmentatie in “baselines” en “line regions”.

Tekstherkenningsfouten op een scan het “Nieuws- en Advertentieblad van Herenthals” in Transkribus houden verband met de segmentatie van de complexe lay-out van de krant. De uitzonderlijke tekengrootte van de krantenkop HERENTHALS genereert een onderbroken “baseline” of tekstregel, en een “line region” of polygoon die niet de gehele omtrek van de karakters omvat.

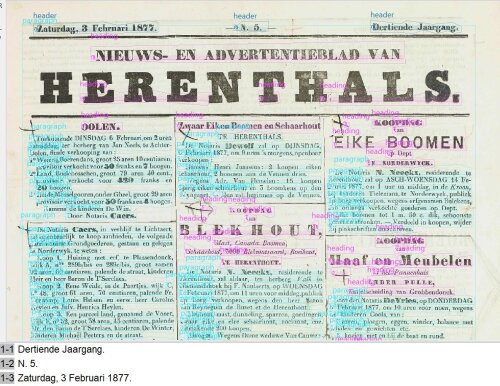

Naast fouten op karakterniveau als gevolg van de segmentatie van de tekstregels, zorgde de opdeling van de krant in kolommen en tabellen voor uitdagingen m.b.t. de leesvolgorde (“reading order”) van de tekstregels. Zonder correctie verlaagt dit de leesbaarheid van de resulterende digitale tekst en de bruikbaarheid ervan voor computeranalyse gebaseerd op tekstuele nabijheid van “named entities”. In de “CITlab Layout Analysis” module van Transkribus werd het neurale netwerk getraind op kranten in het kader van het NewsEye project als wel configuratieoptie opgenomen, maar de resultaten daarvan blijven voorlopig ontoereikend. Aan de CITlab onderzoeksgroep van de Universität Rostock worden de (open source) tools voor krantensegmentatie echter verder ontwikkeld. Dat Transkribus tekstregio’s en tekstregels segmenteert o.b.v. de witruimte tussen de beeldelementen, zorgde tevens dat de interne logica van de tabellen, opgedeeld in rijen en kolommen (met overzicht van loten bij openbare verkopen, marktprijzen voor landbouwproducten, en uurroosters van treinen en buurtspoorwegen), bij de segmentatie niet werd gerespecteerd.

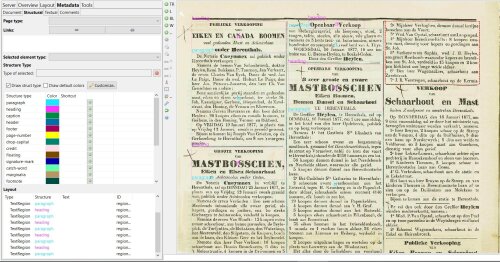

Segmentatie van een scan van het “Nieuws- en Advertentieblad van Herenthals” met de CITlab Advanced standaardconfiguratie (“preset”) en de configuratie voor kranten (“NewsEye”). Hoewel de herkenning van de tekstregels beter is met de “NewsEye” tool, blijft de leesvolgorde incorrect.

Twee opties voor het verbeteren van de lay-outanalyse (en dus de tekstherkenning) in Transkribus blijven over: handmatige segmentatie, of het trainen van een model in P2PaLA. Om het probleem van de leesvolgorde te verhelpen, dient de software de kolommen met gedrukte tekst (en eventueel ook de krantenkoppen) te kunnen onderscheiden. Manueel de zgn. “text regions” of “printed blocks” met de tools voor lay-outanalyse aanduiden blijft de meest nauwkeurige methode, maar tevens de meest arbeidsintensieve (zeker voor een corpus met een complexe lay-out). Aangezien de positionering van de tekst in een krant niet elke editie wijzigt, kan je gebruik maken van de functie “Copy regions (texts or tables) to other pages” om tijd uit te sparen. Controle blijft echter nodig om te verzekeren dat de kolommen op elke pagina correct omrand werden, omdat de uitlijning van de scan blad per blad kan verschillen. Foutieve “text regions” leiden immers tot foutieve segmentatie in tekstregels, enz. Na het handmatig aanduiden van de tekstkolommen, genereerde zowel de “CITlab Advanced LA NewsEye” tool als de tekstherkenning in één fase met de ABBYY segmentatie in het model “Kempense Kranten” getraind, vergelijkbare resultaten op het “Nieuws- en Advertentieblad” corpus voor wat betreft het onderscheiden van tekstregels.

“Page

to Page Layout Analysis” of “P2PaLA” is een tool voor documentsegmentatie waarvan

ook de modeltrainingsfunctionaliteiten in Transkribus werden geïntegreerd. Net

als bij de HTR-training is er de keuze tussen publieke modellen die ter

beschikking staan van alle gebruikers, of om een model te trainen op je eigen bronnenmateriaal.

Het neurale netwerk traint op het onderscheiden van diverse typen

beeldelementen a.d.h.v. de “structure tags” die je aan de “text regions”

toekent. Je kan ervoor kiezen om daarnaast ook de “baselines” te trainen (de

“line regions” m.b.t. tekengrootte echter niet). De structuurtypen omvatten o.m. “paragraph”, “heading”, “header” en “footer”,

“marginalia” en “book-binding”. Het is mogelijk om eigen tags toe te voegen, zoals

“paragraph-left”, “paragraph-right”, of eventueel “column”/“printed block”. De

structuurtraining dient twee doelen, die we in het geval van het “Nieuws- en

Advertentieblad” als aan elkaar tegengesteld ervaarden: het toevoegen van

“mark-up” aan de XML-output van de digitale tekst, en het trainen van een model

voor automatische segmentatie o.b.v. structuurherkenning. Met het oog op de

volgende fase van data-extractie uit de machine-leesbare tekst, is de “mark-up”

bij voorkeur voldoende gedetailleerd. Idealiter wordt elke paragraaf die

informatie bevat over één welbepaalde locatie als afzonderlijk element

onderscheiden en gemarkeerd. Voor het segmenteren van het document in

krantenkoppen en kolommen met het oog op de leesvolgorde, cruciaal voor de

bruikbaarheid van de digitale tekst met “Natural Language Processing”, is

dergelijke graad van detail overbodig - en, leerde de ondervinding - zelfs

contraproductief.

Structuurtags in Transkribus op een trainingscorpus geselecteerd uit de scans van het “Nieuws- en Advertentieblad van Herenthals”. Een model voor structuurherkenning werd in de P2PaLA tool getraind op 68 bladzijden (17 krantenedities): in totaal 1380 paragrafen, 1022 koppen, en 31295 tekstregels (“baselines”). De structuurtypes “header”, “heading”, en “paragraph” werden onderscheiden.

Met een zo kwalitatief mogelijke output voor de latere tekstanalyse als doel, werd geopteerd voor een gedetailleerde structuurtraining, die niet enkel de krantenkolommen, maar ook de koppen en paragrafen zou kunnen onderscheiden. De resultaten waren slechts gedeeltelijk succesvol. Voor wat betreft het onderscheiden van “text regions” en dus de correcte leesvolgorde van de gedrukte tekstkolommen, had de divisie tussen koppen en paragrafen ervoor gezorgd dat artikels zonder kop als één paragraaf werden gesegmenteerd, en dat over de kolommen heen. De segmentatie in “baselines” was bijzonder slecht. P2PaLA kan dus niet als oplossing worden gezien voor het probleem van de onderbroken baselines bij krantenkoppen met een afwijkende tekengrootte, of voor de correctie van de rijen in tabellen. Met een P2PaLA model kan je echter ook structuurtags toevoegen aan een reeds getranscribeerd document: daarop presteerde ons model uitstekend. In conclusie kunnen we stellen dat, voor documenten met een complexe lay-out en een variabele positie van de beeldelementen (zoals krantenkoppen), niet één enkel model beide doelen van de structuurtraining kan dienen. Segmentatie van het afgebeelde document en verrijking van de digitale tekst met mark-up vroegen in het geval van het “Nieuws- en Advertentieblad” een afzonderlijke modellering.

Resultaten van de segmentatie van het “Nieuws- en Advertentieblad van Herenthals” met het model getraind in de P2PaLA tool. Het onderscheiden van hoofdingen en paragrafen gebeurt over de krantenkolommen heen. De herkenning van tekstregels (“baselines”) is bijzonder onregelmatig.

Toepassing van de structuren getraind in P2PaLA op een reeds gesegmenteerde en getranscribeerde tekst. De “structure tags” werden bijzonder accuraat toegekend, hier aan de individuele tekstregels. Om betekenisvol te zijn voor de informatie-extractie met “Natural Language Processing”, worden de geannoteerde tekstregels echter beter als paragraaf (“text region”) gegroepeerd.